251 episodes

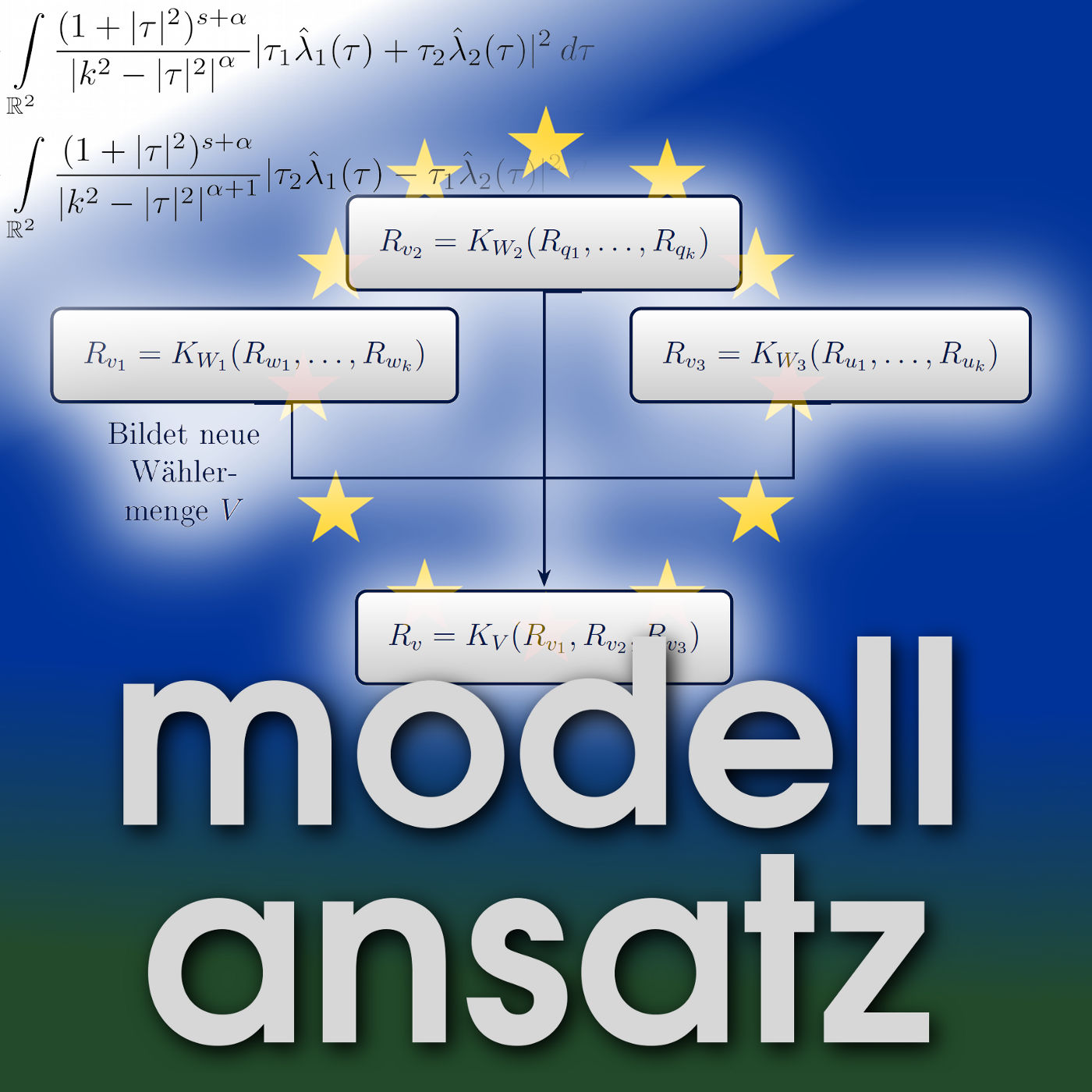

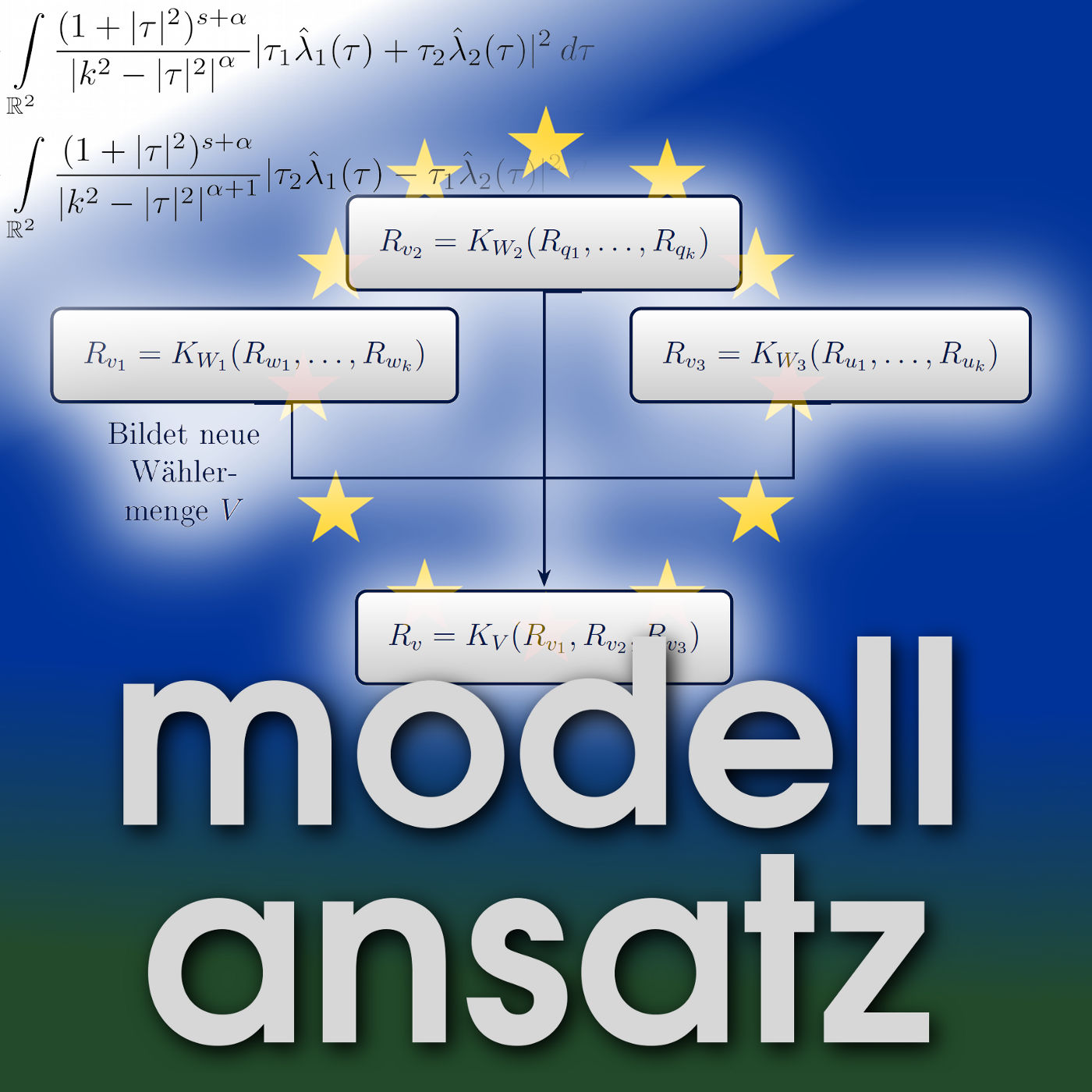

Gudrun sprach im Januar 2024 mit zwei Studenten ihrer Vorlesung Mathematical Modelling and Simulation: Lukas Ullmer und Moritz Vogel. Sie hatten in ihrem Projekt Wahlmodelle ananlysiert. In dem Gespräch geht es darum, wie man hierfür mathematische Modelle findet, ob man Wahlsysteme https://de.wikipedia.org/wiki/Wahlsystem fair gestalten kann und was sie aus den von ihnen gewählten Beispielen gelernt haben. Der Fokus ihrer Projektarbeit liegt auf der Betrachtung und Analyse von Wahlen, in denen mehrere verschiedene Wähler zu einem Thema abstimmen. Formal von Relevanz sind hierbei die sogenannten Wahlsysteme https://de.wikipedia.org/wiki/Wahlsystem, welche die Art der Aggregation der Wählerstimmen beschreiben. Diese fallen in der Praxis recht vielfältig aus und über die Jahre wurden verschiedenste Wahlsysteme vorgeschlagen, angewendet und auch analysiert. In dieser Arbeit werden drei Kategorien präferenzbasierter Wahlsysteme analysiert: vergleichsbasierte Systeme, Scoring-Systeme sowie Approval-Systeme. Aufbauend darauf erfolgt die Konstruktion mehrstufiger und hybrider Wahlsysteme. Desweiteren werden verschiedenen Wahleigenschaften wie z.B. die Nicht-Diktatur oder die Strategiesicherheit betrachtet. Diese meist wünschenswerten Eigenschaften schließen sich teilweise gegenseitig aus. Die Themen Wahlmanipulation und Wahlkontrolle liegen deshalb besonders im Fokus. LITERATUR UND WEITERFÜHRENDE INFORMATIONEN __ __ PODCASTS __ __

In dieser Folge geht es darum, wie Sebastian und Gudrun Mathematik an Hochschulen unterrichten und welche Rollen das Medium Podcast und konkret unser Podcast Modellansatz dabei spielen. Die Fragen stellte unsere Hörerin Franziska Blendin, die in der Folge 233 http://modellansatz.de/fernstudium-maschinenbau im Jahr 2020 über Ihr Fernstudium Bachelor Maschinenbau http://modellansatz.de/fernstudium-maschinenbau berichtet hatte. Sie hatte uns vorab gefragt: "Was versprecht ihr euch von dem Podcast - was ist euer Fazit nach den Jahren den ihr ihn schon macht und wie gestaltet ihr warum Lehre? Was macht euch Spaß, was sind Herausforderungen, was frustriert euch? Warum und wie gestaltet ihr Lehre für Studierende außerhalb der Mathematik, also beispielsweise Maschinenbau?" Es ist ein bisschen lustig, dass die erste Folge Modellansatz, in der Sebastian und Gudrun sich spontan ein Thema zum reden suchten ausgerechnet ein Gespräch über eine neu konzipierte Vorlesung war und der Podcast diese Vorlesung bis heute in unterschiedlichen Rollen begleitet, obwohl das nicht zum ursprünglichen Plan gehörte, wie wir uns einen Podcast über Mathematik vorgestellt hatten. Einerseits haben viele kein Verständnis dafür, was alles mit Mathe gemacht werden kann, andererseits erleben wir intern andauernd so viele spannenden Vorträge und Personen. Eigentlich bringen wir die beiden Sachen in unserem Podcast nur zusammen. Das Medium Podcast ist dabei durch das Gespräch sehr niederschwellig: Es ist so sehr leicht mit den Gesprächen in die Themen einzusteigen und auch auf viel weiteren Ebenen sich darüber zu unterhalten. Wir sind überzeugt, dass wir mit Text oder Video nie so viele und so umfangreiche Austauschsformen einfangen können, mal ganz abgesehen davon, dass die Formate dann an sich für uns zu einer viel größeren Herausforderung in Form und Darstellung geworden wären. Wir hoffen, dass sich irgendwann auch mal eine Person dazu bekennt, wegen unseres Podcasts ein Mathe- oder Informatikstudium zu erwägen, aber bisher ist das tolle Feedback an sich ja schon eine ganz ausgezeichnete Bestätigung, dass diese Gespräche und Themen nicht nur uns interessieren. Viele der Gespräche haben sich auch schon vielfach für uns gelohnt: Sebastian hat aus vielen Gesprächen Inspirationen für Vorlesungen oder andere Umsetzungen gewonnen. Ein Fazit ist auf jeden Fall, dass das Ganze noch lange nicht auserzählt ist, aber wir auch nicht außerhalb unserer Umgebung leben. In der Pandemie sind einerseits Gespräche am Tisch gegenüber, wie wir sie gerne führen, schwierig geworden, und gleichzeitig ist die Lehre so viel aufwendiger geworden, dass kaum Zeit verblieb. Aufnahmen, waren zuletzt hauptsächlich "interne" Podcasts für Vorlesungen, damit die Studierenden daheim und unterwegs sich mit den Inhalten auseinandersetzen können. Gudrun hat damit auch Themen vorbereitet, die sie anschließend in die Zeitschrift Mitteilungen der Deutschen Mathematiker-Vereinigung als Artikel geschrieben hat. Das betrifft insbesondere die Folgen zu Allyship und zum Mentoring in der Mathematik. In der Vermittlung von Mathematik im Studium gibt es kaum Themen, die nicht irgendwo spannend und interessant sind. Um die Themen zu verstehen oder wie dort die Lösungen oder Verfahren gefunden wurden, muss die Theorie behandelt und in weiten Teilen verstanden werden. Da aber "Rosinenpickerei" nichts bringt (also nur die nötigsten Teile von Theorie zu erzählen), geht es darum, ein sinnvolles Mittelmaß zu finden. Also auf der einen Seite ein gutes Fundament aufzubauen zu einem Thema, aber gleichzeitig noch Zeit für Einblicke in spannende und interessante Teile zu haben. Es ist in der Vorbereitung auf der einen Seite total schön, wenn dann eine Anwendung perfekt in die Theorie passt, beispielsweise entwirft Sebastian gerade ein Skript zu formalen Sprachen und Grammatiken, und dann kann man das Komprimierverfahren LZW https://de.wikipedia.org/wiki/Lempel-Ziv-Welch-Algorithmus als eine dynamische Grammatik sehen. Oder es geht um theoretische und "langweilige" Zustandsmaschinen und dann gibt es das Beispiel, dass die Raspberry Pi Foundation gerade dazu einen eigenen Chip (RP2040 https://www.raspberrypi.com/documentation/microcontrollers/rp2040.html) mit solchen Komponenten veröffentlicht, oder mit dem Newton-Verfahren wurde die schnelle Quadratwurzel für das Computerspiel Quake https://media.ccc.de/v/gpn20-91-0x5f3759df-ein-wtf-fr-mehr-fps erst möglich. Ob das dann auch so toll in der Vorlesung herüberkommt, ist nochmal ein eigenes Thema, aber wenn es klappt, so ist das natürlich großartig. Umgekehrt frustriert es dann schon, wenn die Grundlagen nicht bei möglichst vielen ankommen- nicht jede Person muss sich ja bis ins letzte für ein Thema begeistern, aber am Ende sollte der Großteil die wichtigen Hauptsachen mitnehmen. Leider gibt es immer ein paar Leute, wo das dann trotz vieler Angebote leider nicht so gut klappt, und das frustriert natürlich. Dann muss geschaut werden, woran es liegen könnte. Aktuell hilft das Nörgeln und Nerven, wenn nicht regelmäßig die angebotenen Übungsaufgaben abgegeben werden, wohl mit am Besten. Warum werden mathematische Themen im Ingenieurstudium relevant: Das hängt ganz davon ab, welche Kurse wir haben, und was gebraucht wird... Sebastian unterrichtet jetzt gerade Informatik-Studierende und in den Wirtschaftswissenschaften, früher außer MACH/CIW/BIW/MAGE... auch mal Mathe-Lehrende. Das "Wie" ist dann jeweils auf die Gruppe zugeschnitten: Zunächst gibt es ja unterschiedliche Voraussetzungen: Curriculum, Haupt- & Nebenfächer, etc.. Dann gibt es eine Liste von Fertigkeiten, die vermittelt werden sollen und können, und dann besonders in den Vorlesungen außerhalb des Mathematik-Studiums die lästige Beschränkung des Umfangs der Veranstaltung, und wieviel Eigenarbeit erwartet werden kann. Grundsätzlich möchten wir auch bei den Nicht-Hauptfächlern so viel davon erzählen, was dahinter steht- statt "ist halt so"- und was heute damit gemacht werden kann. Diese Motivation macht vielen das Lernen leichter. Es muss aber auch immer viel selbst gemacht werden, dh. viele Aufgaben und prototypische Problemlösungen, denn Mathe lernt sich nicht durchs zuhören alleine. (leider... ;) Damit geht das Puzzle-Spiel los: Welche Grundlagen müssen aufgebaut werden, und was kann wie in der gegebenen Zeit sinnvoll behandelt werden... Und natürlich immer mit dem Blick darauf, ob es Anküpfungspunkte in die Studienrichtungen der Studierenden gibt. LITERATUR UND WEITERFÜHRENDE INFORMATIONEN __ __ PODCASTS VON FRANZISKA __ __ PODCASTS ZUM THEMA MATHE IN DER HOCHSCHULLEHRE __ __ PODCASTS ALS PROJEKTABSCHLUSS __ __ WEITERE ERWÄHNTE PODCASTS, ARTIKEL UND VORTRÄGE __ __

Gudrun unterhält sich in dieser Folge mit Waltraud Kahle. Sie war bis 2018 als außerplanmäßige Professorin in der Fakultät für Mathematik https://www.math.ovgu.de/ an der Otto von Guericke Universität https://www.ovgu.de/ in Magdeburg beschäftigt und war Mitglied des Instituts für Mathematische Stochastik https://www.math.ovgu.de/Institute/IMST.html. Das Thema des Gespräches ist das Forschungsthema von Waltraud: Statistik für zensierte Daten und in Abnutzungsprozessen sowie unvollständige Reparatur. Das Gespräch beginnt mit der Frage: Wie kann man Aussagen darüber treffen, wie lange technische Objekte oder auch Menschen "leben" . Ungefähre Aussagen hierzu für große Gruppen sind in der Industrie, der Demographie und Versicherungsmathematik und Medizin nötig. Es ist ein statistisches Problem, das sich in der Theorie auf eine (möglichst große) Anzahl von Beobachtungen bezieht aus denen dann Schlussfolgerungen abgeleitet werden, die für ähnliche Prozesse auch zu Vorhersagen dienen können. In der Praxis liegen aber in der Regel nur zensierte Daten https://de.wikipedia.org/wiki/Zensierte_Daten vor, denn die Beobachtung muss abgebrochen werden, bevor die vollständige Information vorliegt. Ein alternativer Zugang ist es nun, nicht nach der Lebensdauer zu fragen sondern die der Lebensdauer zugrunde liegenden Abnutzungsprozesse zu modellieren (z.B. Verschleiß und Ermüdung). Hier verwendet man stochastische Prozesse, wie zum Beispiel den Wienerprozess https://de.wikipedia.org/wiki/Wienerprozess. Grundlegende Eigenschaft des Wienerprozesses ist es, dass in jedem Zeitintervall ein normalverteilter Zuwachs erfolgt und alle diese Zuwächse voneinander unabhängig sind. Ein Ausfall erfolgt, wenn der Abnutzungsprozess ein vorgegebenes Niveau erstmalig erreicht. Man fragt sich folglich: Wie ist die Verteilung dieser "Erstüberschreitungszeit". Zur Vermeidung von Ausfällen können regelmäßig vorbeugende Instandhaltungsmaßnahmen durchgeführt werden, die das Abnutzungsniveau verringern. Das kann mit festen Intervallen oder nach vorgegebenen Ereignissen stattfinden. Zu DDR-Zeiten gab es z.B. ein Projekt, dass sicherstellen konnte, das notwendige Wartungsarbeiten von Mähdreschern nur im Winter erfolgten, damit sie zur Erntesaison voll einsatzfähig waren. Das statistische Modell muss Aussagen zu folgenden Fragen treffen können __ __ Andere Modellierungsmöglichkeiten bieten Gammaprozesse oder inhomogene Poissonprozesse https://de.wikipedia.org/wiki/Poisson-Prozess. Im Gespräch gehen Gudrun und Waltraud auf Eigenschaften der Normalverteilung https://de.wikipedia.org/wiki/Normalverteilung ein. Sie besprechen die Exponentialverteilung https://de.wikipedia.org/wiki/Exponentialverteilung (diese hat eine konstante Ausfallrate https://de.wikipedia.org/wiki/Ausfallrate). Das beschreibt elektronische Bauteile mit langer Lebensdauer sehr gut. Außerdem geht es um die Weibull-Verteilung https://de.wikipedia.org/wiki/Weibull-Verteilung. Diese passt auf Systeme mit sehr vielen Teilen (das Modell nimmt hier sogar unendlich viele Teile), die mit geringer Wahrscheinlichkeit ausfallen und wo das System ausfällt, sobald das erste Glied ausgefallen ist. Diese Verteilung hat die praktische Eigenschaft, dass die in der Medizin verwendeten Modelle der proportionalen Ausfallrate und der proportionalen Lebensdauer übereinstimmen. Waltraud engaiert sich im eLeMeNTe https://www.elemente.org/ e.V.. Das ist der Landesverein Sachsen-Anhalt zur Förderung mathematisch, naturwissenschaftlich und technisch interessierter und talentierter Schülerinnen, Schüler und Studierender. Ein Ziel ist es, die Landesolympiaden Mathematik in Sachsen-Anhalt durchzuführen und Schülerinnen und Schüler mit speziellen Arbeitsgemeinschaften auf die Wettbewerbe vorzubereiten. Waltraud findet es spannend, dort oft überraschenden Ideen der Kinder und jungen Leute zu begegnen, die noch nicht in den ausgetretenen Denkpfaden unterwegs sind. Zur Geschichte der Mathe-Olympiaden https://de.wikipedia.org/wiki/Mathematik-Olympiade_in_Deutschland finden sich auf Wikipedia folgende Informationen (die Gudrun aus eigenem Erleben bestätigen kann): "Die erste Mathematik-Olympiade in der DDR fand 1961/62 als „Olympiade Junger Mathematiker“ statt. Seitdem gab es dort ab der 5. Klassenstufe Schul- und Kreisolympiaden, ab der 7. Klassenstufe Bezirksolympiaden und ab der 10. Klassenstufe DDR-Olympiaden, an der aber auch sogenannte Frühstarter aus tieferen Klassenstufen teilnahmen. Der DDR-Ausscheid fand zunächst in der Woche vor Ostern jeden Jahres in der Jugendhochschule „Wilhelm Pieck“ bei Berlin, später im Mai in Erfurt statt. ... Auf allen Ebenen gab es zur Unterstützung begabter Schüler Mathematikzirkel....Nach der Wiedervereinigung Deutschlands entwickelte sich die Mathematikolympiade schnell zu einem bundesweiten Schülerwettbewerb. Seit 1994 ist der Mathematik-Olympiaden e.V. Träger des Wettbewerbs, der in Kooperation mit dem Talentförderzentrum Bildung & Begabung jährlich ausgeschrieben wird. Seit 1996 nehmen alle 16 Bundesländer an der Bundesrunde teil." Die Bundesrunde fand 1993, 1994 und 2001 in Magdeburg stattt. * REFERENZEN UND WEITERE INFORMATIONEN __ __ __ __

Gudrun spricht in dieser Folge mit Anshuman Chauhan https://www.mvm.kit.edu/Mitarbeiter_MVM_5811.php über sein Masterstudium Computational Sciences in Engineering https://www.tu-braunschweig.de/cse/what-is-cse (CSE) an der TU Braunschweig https://www.tu-braunschweig.de/. CSE ist dort ein viersemestriger Masterstudiengang, der etwa zur Hälfte in Englisch und zur anderen Hälfte in Deutsch unterrichtet wird. Er ist an der Fakultät Architektur, Bauingenieurwesen und Umweltwissenschaften angesiedelt, kombiniert aber in der Ausbildung Ingenieurwissenschaften, Mathematik und angewandte Informatik. In gewisser Weise ist es eine konsequente Weiterentwicklung der Idee der Technischen Universitäten deutscher Prägung, dass heute solche interdisziplinären Studiengänge angeboten werden. So wie das heutige KIT wurden sie ja häufig als Polytechnische Schulen gegründet, in denen zunächst das was wir heute Maschinenbau nennen mathematisiert wurde, um mit der Entwicklung der Technik Schritt halten zu können. In zunehmenden Maße waren dann immer mehr technische Fächer ohne eigene Forschung und auch ohne eine Grundausbildung in Mathematik nicht mehr denkbar. Heute hält nun endgülitg zunächst die Computersimulation aber zunehmend auch die Benutzung von Algorithmischem Lernen und Big Data Einzug in die Ingenieurwissenschaften. Diese Entwicklung wird mit Spezialisierungen in der Mathematik, insbesondere in den Studiengängen Technomathematik, in Spezialisierungen in den Ingenieurwissenschaften, aber auch durch die Schaffung von neuartigen Studiengängen begleitet, die im Namen wie in der Ausbildung mindestens zwei, oft aber drei Standbeine haben: Mathematik, Informatik und eine technische Anwendung. Anshuman ist in Neu-Dehli aufgewachsen. Nach seiner Bachelorarbeit zu Finite Element Methoden hatte er sich weltweit nach Studiengängen umgeschaut, die mit Computersimulation zu tun haben - am liebsten mit Aerodynamik für Autos. Deutschland war für ihn dabei attraktiv, weil es renommierte Technische Universitäten hat und die Kosten nicht exorbitant sind. Er entschied sich für die TU in Braunschweig aufgrund eben dieses Renomees der deutschen TU9 https://de.wikipedia.org/wiki/TU9. Sie hat zur Zeit etwa 20.000 Studierende in fast 80 Studiengänge. Seit 2018 gibt es einen Exzellenzcluster in Luftfahrt und Metrologie und der DLR ist in der Nähe. Im Gespräch erläutert Anshuman, dass er mit der Entscheidung für Braunschweig und für diesen Studiengang sehr zufrieden ist. Er ist nun nach erfolgreichem Abschluss und einiger Zeit in der Wirtschaft seit 2020 am KIT im Graduiertenkolleg SiMet https://www.simet.kit.edu/, wo der Kontakt mit dem Podcast zustande kam. Braunschweig hat ein richtiges Stadtleben, das von den vielen Studierenden dort mit geprägt ist. Anshuman ist dort in einem Studentenwohnheim untergekommen und hatte sofort sozial Anschluss. In dem von ihm in Braunschweig belegten Masterprogramm CSE ist jedes Semester aufgeteilt zwischen Ingenieurfächern, Mathematik und Informatik. Zum Beispiel die Fächer Strömungsdynamik und Thermodynamik zusammen mit partiellen Differentialgleichungen in der Mathematik und Visualisierung im Informatikteil. Später sind dann Vertiefungskurse in z.B. Maschinenbau, Elektrotechnik, Bauingenieurwesen oder Informatik wählbar. Die Numerischen Methoden in der Aerodynamik z.B. waren sehr praxisnah. Er wollte seine Masterarbeit unbedingt in der Industrie schreiben, um Erfahrung in einem Unternehmen zu sammeln. Er sah aber sehr schnell, dass richtig Deutsch zu lernen dafür eine notwendige Voraussetzung ist. Deshalb nahm er sich ein Semester Zeit, um die Sprache noch besser zu üben und außerdem einige für ihn sehr interessante Kurse zu belegen, zu denen er vorher keine Zeit gehabt hatte. Überdies hat er auch noch spanisch belegt. Mit der deutschen Bewerbung hat es schließlich mit einer Masterarbeit in Stuttgart geklappt. Der Wechsel von Braunschweig in Norddeutschland nach Stuttgart in Süddeutschland war für ihn sehr spürbar - es ist einfach ein anderer Schlag Menschen. In der Firma gibt es natürlich vorgeschriebene Prozesse, in die man sich erst einarbeiten muss. Sie bringen aber eine gewisse Robustheit in die Entwicklung. Als Masterstudent hatte er trotzdem genug Freiheit und eine tolle Betreuung. In der Industrietätigkeit nach seinem Masterabschluss musste er sich oft schnell in die Probleme einarbeiten und konnte nicht so gründlich, sein wie er es aus der Studienzeit gewohnt war. Er beschäftigte sich mit der Optimierung am Einlasskanal in einem Motor mit Hilfe von Strömungsrechnung (CFD). D.h. er hatte sein ursprüngliches Traumziel eigentlich erreicht. Trotzdem war es ihm dann zu viel Routine und er wollte noch mehr über ein Zukunftsthema für Autos lernen: konkret über Batterien. Das kann er nun während der Promotion im Rahmen von SiMET tun. Hier ist er wieder in einem Umfeld von anderen jungen Menschen, die sehr unterschiedliche Masterabschlüsse erworben haben und Mathematik, Computer und die Anwendungsthemen alle verstehen müssen. PODCASTS __ __

Gudrun hatte 2018 mit Carla Cederbaum https://uni-tuebingen.de/fakultaeten/mathematisch-naturwissenschaftliche-fakultaet/fachbereiche/mathematik/fachbereich/forschung-arbeitsbereiche/geometrische-analysis-differentialgeometrie-und-relativitaetstheorie/personen/prof-dr-carla-cederbaum/ über mathematische Konzepte gesprochen http://modellansatz.de/sternenschwerpunkt, mit denen man z.B. den Schwerpunkt von Sternen bestimmen kann. Im April 2022 trafen sich beide erneut zum Gespräch - diesmal per Videokonferenz. Carla ist inzwischen Professorin an der Uni Tübingen in der AG Geometrische Analysis, Differentialgeometrie und Relativitätstheorie und erhielt den Tübinger Preis für Wissenschaftskommunikation des Jahres 2022. Seit 2021 arbeiten Gudrun und Carla zusammen bei der Gestaltung der Zeitschrift Mitteilungen der Deutschen Mathematiker Vereinigung https://www.degruyter.com/journal/key/dmvm/html?lang=de (MDMV). Gudrun ist 2021-24 als Herausgeberin verantwortlich für die Inhalte und hat neben drei anderen Kolleginnen und Kollegen auch Carla als Mitherausgeberin gewonnen. Im Gespräch geht es um das Praxishandbuch zum Mentoring von Frauen in der mathematischen Forschung https://mentoring.spp2026.de/, das unter der Creative Commons Lizenz CC-BY-SA 4.0 https://creativecommons.org/licenses/by-sa/4.0/ allen Interessierten zur Verfügung steht und an dessen Weiterentwicklung (auch aufgrund der offenen Lizenz) alle mitarbeiten können. Das Handbuch wurde von Carla Cederbaum, Sophia Jahns und Anna Wienhard https://www.mathi.uni-heidelberg.de/~wienhard/ im Rahmen des Schwerpunktprogramms SPP2026 Geometrie im Unendlichen https://www.spp2026.de/ der Deutschen Forschungsgemeinschaft (DFG) verfasst und basiert auf den Erfahrungen mit dem Math Ment♀ring Programm an der Universität Tübingen unter der Leitung von Carla einerseits und dem UPSTREAM Mentoring Netzwerk an der Universität Heidelberg unter der Leitung von Anna (und Michael Winckler) andererseits. (*) Mentoring gibt es heutzutage in vielen Zusammenhängen und kann konkret sehr viel Unterschiedliches bedeuten. Die Idee, ein spezielles Mentoring für Frauen an ihrem Fachbereich in Tübingen anzubieten, erwuchs aus Carlas eigenen Erfahrungen. Seit ihrem Studium in Freiburg erlebte sie, wie die Tatsache, einer Minderheit im Fach anzugehören, Frauen auf vielfältige Weise dabei behindert, sich in der Mathematik kompetent und in der Fachkultur heimisch zu fühlen. Inzwischen ist gut mit konkreten Zahlen belegt, dass beim Übergang von jeder Entwicklungsstufe auf die nächste in der akademischen Laufbahn mehr Frauen als Männer das Fach verlassen. D.h. bei jedem Karriereschritt sinkt der Anteil von Frauen. So gehen Talente verloren und das Fach Mathematik verliert als Ganzes. In vielen Universitäten hat man das inzwischen als Problem erkannt, dem man strukturell begegnen möchte, aber es gibt oft eine gewisse Ratlosigkeit, wie das geschehen kann. Carla und ihre Mitstreiterinnen sehen als einen Baustein in der Lösung dieses Problems die Wichtigkeit des Austauschs unter Frauen in einem geschützten Rahmen. Dies ist ein effektiver und vergleichsweise kostengünsitger Ansatz. Es geht nicht darum, Frauen zu einer Karriere in der Mathematik zu überreden, sondern diejenigen zu finden und zu unterstützen, die Lust und Talent dazu haben. Unterschiedliche Ausgangssituationen und fehlende Privilegien können so abgemildert werden. An der Duke University baute Carla erstmals Mentoring von und für Frauen in der Mathematik auf, u.a. mit Ingrid Daubechies https://de.wikipedia.org/wiki/Ingrid_Daubechies. Für Tübingen hat sie daraus das Format übernommen, dass die Mentorin der Mentee in der Regel eine Stufe in der Karriereleiter voraus ist. So kann man sich noch recht einfach hineindenken, wie man selbst noch vor kurzem gedacht und gearbeitet hat - außerdem ist es ideal, wenn man selbst als Mentee in einem weiteren "Gespann" die "andere Seite" des Mentorings erlebt. In jedem Fall ist es hilfreich, wenn Mentorinnen eine Schulung oder zumindest eine Handreichung bekommen, bevor sie diese Rolle übernehmen. Im Handbuch ist erprobtes Material für die Schulung der Mentorinnen zusammengetragen (inkl. aller möglicher Vorlagen für Anschreiben, Aushänge etc.). Eine ausführliche und weiter wachsende Literatursammlung zu Mentoring und Gender Studies rundet das Material ab. Die grundlegende Struktur des Mentorings ruht außerdem auf folgenden Prinzipien: __ __ In Tübingen dauert die Mentorinnenschulung 1/2 Tag und konzentriert sich auf die Frage: Was ist Mentoring und was nicht und wie kann ich das konkret gestalten. In einem ersten Teil der Schulung werden typische Argumente und belegte Fakten erörtert, die für und gegen die Notwendigkeit der Unterstützung von Frauen in der Mathematik sprechen. Dafür hat sich das Format der Fishbowl-Diskussion zwischen zwei ausgelosten Gruppen bewährt. Danach werden offenes und proaktives Zuhören geübt und Antworten auf typische Mentoringfragen in unterschiedlichen Karrierestufen gesammelt. Das geschieht in 3er-Gruppen mit den Rollen Mentee/Mentorin/Beobachterin. Jede Gruppe zieht zufällig eine Vignette und spielt ein Gespräch zur dort geschilderten Situation durch. Anschließend erfolgt jeweils eine Besprechung dazu, wie die Personen die Gespräche in den unterschiedlichen Rollen wahrgenommen haben, was gut funktioniert hat und was vielleicht nicht so gut gelaufen ist. Danach werden die Rollen getauscht. Schließlich wird im dritten Teil der Schulung das erste Treffen mit einer Mentee vorbereitet, um eventuelle Nervosität oder Anspannung abzubauen. Man arbeitet in Paaren, um sich das erste Treffen möglichst genau vorzustellen. Hierbei werden die Paare von Schlüsselfragen geleitet. Auch werden Anlaufstellen für über das Mentoring hinausgehende Fragestellungen vorgestellt. Im Handbuch sind zu allen Teilen der Schulung viele Fallbeispiele und Schlüsselfragen gesammelt. Daneben finden sich Vorlagen für Werbung, Organisatorisches zu Treffen und zur Kontaktaufnahme. Es sind aber auch Verweise auf Ressourcen gesammelt, falls es ernsthafte Probleme gibt, die im Mentoringgespräch nicht gelöst werden können (wie z.B. Prüfungsangst, finanzielle Sorgen oder eine psychische Krise). Es wird dafür sensibilisiert, wie man erkennen kann, für welche Fragen man selbst eine kompetente Ansprechperson ist und dass es im Mentoring nicht darum geht ein "Mini-me" zu erziehen - nicht alles was für mich funktioniert hat, ist auch für das Gegenüber gut. Deshalb ist es wichtig, die Werte des Gegenübers herausfinden und dann die Zielsetzung der gemeinsamen Zeit möglichst danach auszurichten. Das Mentoring in Tübingen hat 2014/15 begonnen - der Übergang zur Postdoc-Phase scheint vor Ort das größte Leck zu sein. Als Gründe nennen die Mentees, dass eine akademische Laufbahn sich schwer mit Familiengründung und Partnerschaft vertrage, wenn in der Postdoc-Phase 2-3 längere Auslansdaufenthalte oder wenigstens Wechsel zwischen deutschen Universitäten erwartet werden. Gudrun hat für den Podcast mit drei Frauen gesprochen, die in Tübingen am Mentoringprogramm teilgenommen haben und inzwischen auf der nächsten Karrierestufe arbeiten. Das Gespräch mit Polyxeni Spiloti ist schon veröffentlicht. Die Gespräche mit Cornelia Vogel und Alix Richter folgen bald. Cornelia und Alix waren als Studentinnen Mentees und haben sich jeweils für eine Promotion entschieden, an der sie zur Zeit des Gespräches in Tübingen bzw. Paderborn arbeiteten. (*) Zusätzliche Förderung erhielt das Projekt durch die Duke University, das Zukunftskonzept der Universität Tübingen (DFG, ZUK 63) und durch das Athene-Mentoring Programm, Universität Tübingen, die HGS MathComp https://www.mathcomp.uni-heidelberg.de/home am IWR Heidelberg, den Exzellenzcluster STRUCTURES und die Research Station Geometry & Dynamics der Universität Heidelberg. * REFERENZEN UND WEITERE INFORMATIONEN __ __ * PODCASTS __ __

Gudrun talks with Polyxeni Spilioti https://www.polyxenispilioti.com/ at Aarhus university https://international.au.dk/ about spectral geometry https://en.wikipedia.org/wiki/Spectral_geometry. Before working in Aarhus Polyxeni was a postdoctoral researcher in the group of Anton Deitmar at the University of Tübingen. She received her PhD from the University of Bonn, under the supervision of Werner Mueller after earning her Master's at the National and Technical University of Athens (Faculty of Applied Mathematics and Physics). As postdoc she was also guest at the MPI for Mathematics in Bonn https://www.mpim-bonn.mpg.de/en, the Institut des Hautes Etudes Scientifiques https://www.ihes.fr/en/ in Paris and the Oberwolfach Research Institute for Mathematics https://www.mfo.de/. In her research she works on questions like: How can one obtain information about the geometry of a manifold https://en.wikipedia.org/wiki/Manifold, such as the volume, the curvature, or the length of the closed geodesics https://en.wikipedia.org/wiki/Geodesic, provided that we can study the spectrum of certain differential operators? Harmonic analysis on locally symmetric spaces provides a powerful machinery in studying various invariants, such as the analytic torsion https://en.wikipedia.org/wiki/Analytic_torsion, as well as the dynamical zeta functions https://en.wikipedia.org/wiki/Ruelle_zeta_function of Ruelle and Selberg. * REFERENCES AND FURTHER INFORMATION __ __ * PODCASTS __ __

Gudrun spricht in dieser Folge mit Ute Badde in der Landesanstalt für Umwelt Baden-Württemberg (LUBW) https://www.lubw.baden-wuerttemberg.de/die-lubw am Südende von Karlsruhe. Am 3. Februar, hatte Gudrun mit der Vorlesung Mathematical Modelling and Simulation eine Exkursion in die LUBW unternommen. Geplant war, den Studierenden zu zeigen, wie dort Modelle und Simulationen der Wasserläufe in Karlsruhe eingesetzt werden und mit den Wettervorhersagen als Eingangsdaten arbeiten. Zufällig war es so, dass an diesem Tag eine recht massive Hochwasserlage herrschte. Und zwar nicht aufgrund von außergewöhnlichen oder überraschend heftigen Niederschlägen, sondern aufgrund eines mehrstündigen Landregens. Tatsächlich hätte aufgrund der außerdem noch ungewöhnlich hohen Temperatur noch mehr Wasser unterwegs sein können, wenn auch noch Tauwasser aus den Bergen hinzugekommen wäre. Da es aber in dem Winter zuvor kaum Schnee gegeben hatte, war der Regen der wesentliche Wassereintrag, Jedenfalls war die eigentliche Hochwasserzentrale am Tag der Exkursion besetzt und die Gruppe wich in einen anderen Raum aus. Zum aktuellen Hochwassergeschehen konnte sie aber sehr eindrückliche Informationen mitnehmen. Hochwasser war dann auch ein Thema im späten Frühjahr und in den Sommermonaten 2021. Es gab einige Starkregenereignisse mit Überschwemmungen südlich von Stuttgart und der Rhein war lange Wochen nicht schiffbar und es gab einige Perioden, wo der Auenwald am Rhein überflutet war. Dieses Geschehen in Baden-Württemberg im Auge zu haben und zwar in der Messung und für kurzzeitige und mittelfristige Prognosen ist die Aufgabe der Arbeitsgruppe von Ute Badde an der LUBW. Als Bürger hat man auf diese Daten z.B. Zugriff über die Seiten der Hochwasservorhersage in Baden-Württemberg https://www.hvz.baden-wuerttemberg.de/. Dafür gibt es Zugang zu Messdaten (z.B. Pegelstände) zu unterschiedlichen meteorologischen Modellen und zu einer Armee leistungsstarker Rechner, die dann aus den Daten und den Wettervorhersagen eine Prognose für die Wasserstände der Flüsse wie Rhein, Neckar oder auch den Bodensee berechnen. Damit ist es dann möglich, wenn es brenzlig wird, Gemeinden und Gewerbetreibende zu beraten ob und wenn ja welche Vorsorge vor Ort getroffen werden sollte. Ute hat Bauingenieurwesen am KIT studiert und sich anschließend in der Hydrologie spezialisiert. In die LUBW ist sie zunächst auf einer Projektstelle eingestiegen. Inzwischen hat sie dort eine feste Stelle. Ihr gefällt nach wie vor sehr gut, dass sie an der Schnittstelle von Computern und Modellen ganz Praxis-relevante Fragen beantworten kann und insbesodere in Extremsituationen Entscheidungshilfen geben kann. Außerdem ist es eine schöne Herausforderung, über ihre Arbeit zu berichten. Oft für Zeitungen und das lokale Fernsehen aber diesmal auch im Podcast. * REFERENZEN UND WEITERFÜHRENDE INFORMATIONEN __ __ * PODCASTS __ __

One of the reasons we started this podcast in 2013 was to provide a more realistic picture of mathematics and of the way mathematicians work. On Nov. 19 2021 Gudrun talked to Stephanie Anne Salomone who is Professor and Chair in Mathematics at the University of Portland https://www.up.edu/. She is also Director of the STEM Education and Outreach Center and Faculty Athletic Representative at UP. She is an Associate Director of Project NExT, a program of the Mathematical Association of America that provides networking and professional development opportunities to mathematics faculty who are new to our profession. She is a wife and mother of three boys, Milo (13), Jude (10), and Theodore (8). This conversation started on Twitter in the summer of 2021. There Stephanie (under the twitter handle @SitDownPee https://twitter.com/sitdownpee) and @stanyoshinobu https://twitter.com/stanyoshinobu Dr. Stan Yoshinobu invited their fellow mathematicians to the following workshop: Come help us build gender equity in mathematics! Picture a Mathematician workshop led by @stanyoshinobu Dr. Stan Yoshinobu and me, designed for men in math, but all genders welcome. Gudrun was curious to learn more and followed the provided link: Workshop Abstract http://www.inquirybasedlearning.org/pam Gender equity in the mathematical sciences and in the academy broadly is not yet a reality. Women (and people of color, and other historically excluded groups) are confronted with systemic biases, daily experiences, feelings of not being welcome or included, that in the aggregate push them out of the mathematical sciences. This workshop is designed primarily for men in math (although all genders are welcome to participate) to inform and inspire them to better see some of the key issues with empathy, and then to take action in creating a level-playing field in the academy. Workshop activities include viewing “Picture a Scientist” before the workshop, a 2-hour synchronous workshop via zoom, and follow-up discussions via email and Discord server. *All genders welcome AND this workshop is designed for men to be allies. This idea resonated strongly with Gudrun's experiences: Of course women and other groups which are minorities in research have to speak out to fight for their place but things move forward only if people with power join the cause. At the moment people with power in mathematical research mostly means white men. That is true for the US where Stephanie is working as well as in Germany. Allyship https://en.wikipedia.org/wiki/Allyship is a concept which was introduced by people of colour to name white people fighting for racial justice at their side. Of course, it is a concept which helps in all situations where a group is less powerful than another. Men working for the advancement of non-male mathematicians is strictly necessary in order for equality of chances and a diversity of people in mathematics to be achieved in the next generation. And to be clear: this has nothing to do with counting heads but it is about not ruining the future of mathematics as a discipline by creating obstacles for mathematicians with minoritized identities. The important question is: How is it possible to educate men and especially powerful white men to become allies? The idea of this first workshop designed by Stephanie and Stan was to invite men already interested in learning more and to build a basis with the documentary Picture a scientist https://www.pictureascientist.com/ (2020). * SYNOPSIS PICTURE A SCIENTIST chronicles the groundswell of researchers who are writing a new chapter for women scientists. Biologist Nancy Hopkins, chemist Raychelle Burks, and geologist Jane Willenbring lead viewers on a journey deep into their own experiences in the sciences, ranging from brutal harassment to years of subtle slights. Along the way, from cramped laboratories to spectacular field stations, we encounter scientific luminaries - including social scientists, neuroscientists, and psychologists - who provide new perspectives on how to make science itself more diverse, equitable, and open to all. (from the webpage) In this film there are no mathematicians, but the situations in sciences and mathematics are very similar and for that it lends itself to show the situation. In the podcast conversation Gudrun and Stephanie talk about why and in what way the documentary spoke to them. The huge and small obstacles in their own work as women mathematicians which do not make them feel welcome in a field they feel passionate about. The film shows what happens to women in Science. It shows also men in different roles. Obviously there are the bullies. Then there are the bystanders. There are universities which allow women to be hired and give them the smallest space available. But there are also men who consider themselves friends of their female collaegues who cannot believe that they did not notice how the behaviour of other men (and their own behavior in not taking a side). Seeing this play out over the course of the film is not a comfortable watch, and perhaps because of this discomfort, we hope to build empathy. On the other hand, there is a story of women scientists who noticed that they were not treated as well as their male colleagues and who found each other to fight for office space and the recognition of their work. They succeded a generation ago. The general idea of the workshop was to start with the documentary and to talk about different people and their role in the film in order to take them as prototypical for roles which we happen to observe in our life and which we might happen to play. This discussion in groups was moderated and guided in order to make this a safe space for everyone. Stephanie spoke about how we have to let men grow into their responsibility to speak out against a hostile atmosphere at university created mostly by men. In the workshop it was possible to first develop and then train for possible responses in situations which ask for men stepping in as an ally. The next iteration of the workshop Picture a Mathematician will be on May 11. Biography: Stephanie Salomone earned her Ph.D. in Mathematics from UCLA in 2005 and joined the faculty at the University of Portland that year. She serves as Professor and Chair of Mathematics and Director of the STEM Education and Outreach Center at UP, as well as the Faculty Athletic Representative. She is an Associate Director of Project NExT, a national professional development program for new higher-education mathematics faculty. She was the PI on the NSF REFLECT program, advancing the use of evidence-based practices in STEM teaching at UP and the use of peer-observation for formative assessment of teaching, and has managed a combined $1.6 million as the PI on a subaward of the Western Regional Noyce Alliance grant and as PI of the NSF Noyce Program at UP. She is on the Board of Directors for Saturday Academy, a local 501c3 whose mission is to engage children in hands-on STEM learning. Dr. Salomone is the recipient of UP’s 2009 Outstanding Teaching Award and the recipient of the 2019 Oregon Academy of Sciences Outstanding Educator in STEM Higher Education Award. * LITERATURE AND FURTHER INFORMATION __ __ Science 368, Issue 6497, 1317-1319 (2020). https://doi.org/10.1126/science.aba7377 __ __ * PODCASTS __ __

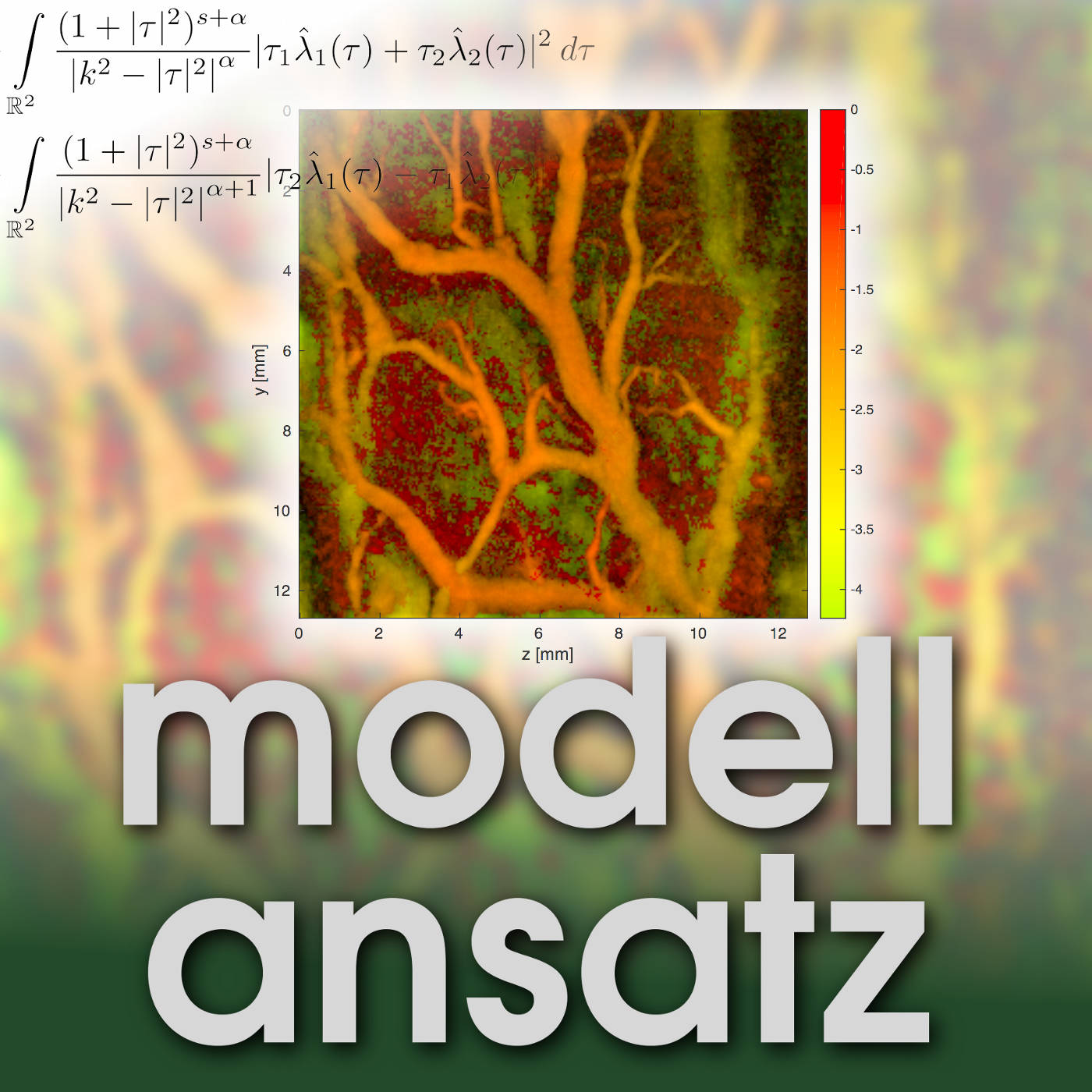

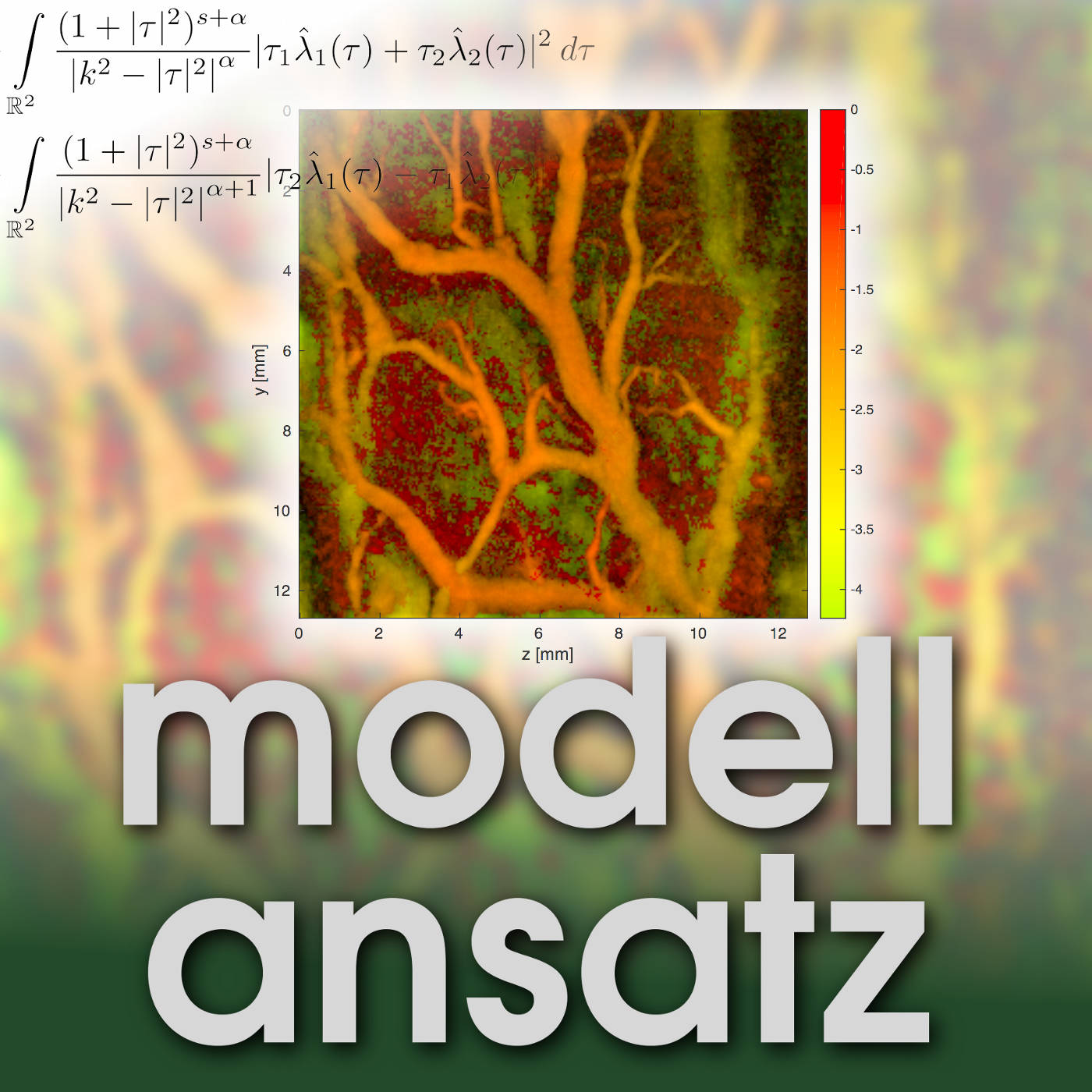

Gudrun spricht in dieser Folge mit Pauline Brumm https://www.sfb1194.tu-darmstadt.de/sfb_1194/kontakt_9/detailseite_sfb1194_166400.de.jsp von der TU Darmstadt https://www.tu-darmstadt.de/ über Benetzung im Tiefdruck. Sie ist wissenschaftliche Mitarbeiterin am Institut für Druckmaschinen und Druckverfahren https://www.idd.tu-darmstadt.de/idd/index.de.jsp und promoviert im SFB 1194 zur Mechanischen Zwangsbenetzung von Oberflächen durch gravierte Tiefdruckzylinder https://www.sfb1194.tu-darmstadt.de/forschung_13/projektbereiche/bereich_c/c01_tiefdruckzylinder/index.de.jsp im Teilprojekt C01. Es handelt sich um eine Weiterführung des Gesprächs mit Dr. Mathis Fricke im Modellansatz-Podcast Folge 242 http://modellansatz.de/dynamische-benetzung über Dynamische Benetzung. Herr Fricke hatte über die Arbeit im SFB 1194 aus Sicht der Mathematik berichtet, Frau Brumm liefert in dieser Folge nun einen Beitrag aus Sicht der Anwendung. Sie hat Maschinenbau im Bachelor und Master an der TU Darmstadt studiert und sich auf Drucktechnik spezialisiert. Drucken wird seit hunderten von Jahren praktiziert und angewendet, jedoch gibt es bisher noch keine umfassende Modellbildung für viele Druckprozesse. Das bedeutet, dass ein Großteil des Wissens empirisch geprägt ist. Firmen stützen sich auf die Erfahrung von gelernten Drucktechnikern, jedoch ist diese Erfahrung nur selten öffentlich zugänglich und es gibt wenige Forschungsinstitute weltweit zum Thema Drucktechnik. Um innovative Anwendungen zu entwickeln, zum Beispiel aus dem Bereich der gedruckten Elektronik, bedarf es jedoch einer detaillierten Modellvorstellung des Druckprozesses, um klassische Druckverfahren aus dem grafischen Druck (Zeitungsdruck, Verpackungsdruck etc.) für den sogenannten „funktionalen Druck“ nutzbar zu machen. Die Schwierigkeit liegt darin, dass an den funktionalen Druck ganz andere Anforderungen gestellt werden, zum Beispiel müssen die gedruckten, häufig ultradünnen Schichten geschlossen, fehlerfrei und von konstanter Schichtdicke sein. Ein häufiger Druckfehler ist das sogenannte „Viscous Fingering“, eine hochdynamische Grenzflächeninstabilität bei der Fluidübertragung, die sich in Form von faszinierenden, verästelten, fingerartigen Strukturen in der gedruckten Schicht bemerkbar macht. Sie sehen so ähnlich aus wie die Arme eines Flussdeltas aus Vogelperspektive oder die Wurzeln von Bäumen. In ihrer Forschung untersucht Frau Brumm diese verästelten Strukturen im Tiefdruck, um sie besser zu verstehen und um den Druckfehler in Zukunft zu verhindern oder für spezielle Anwendungen nutzbar zu machen. Beim Tiefdruck wird die Farbe über gravierte Näpfchen in einem Druckzylinder übertragen. Die Näpfchen liegen vertieft und sind nur wenige zehn Mikrometer groß. Beim Kontakt mit dem zu bedruckenden Substrat (Papier, Folie, Glas…) wird die Druckfarbe unter hohem Druck und hoher Geschwindigkeit aus den Näpfchen herausgesaugt. Es kommt zur Zwangsbenetzung des Substrats. Mit Stokes-Gleichungen kann man Parametermodelle herleiten, welche das Skalierungsverhalten der verästelten, gedruckten Strukturen beschreiben. Zum Beispiel skaliert der dominante Abstand der gedruckten Strukturen mit der Druckgeschwindigkeit hoch minus ein Halb laut Sauer et al. (2015) https://iarigai.com/download/683/, welches dem 60 Jahre alten Skalengesetz von Saffman und Taylor (1958) https://doi.org/10.1098/rspa.1958.0085 entspricht. Mit Experimenten können diese Modelle bestätigt oder widerlegt werden. Die Planung von Experimenten geschieht zielgerichtet. Im Vorfeld muss überlegt werden, welche Parameter im Experiment variiert werden sollen und wie viele Messpunkte benötigt werden, um statistisch abgesicherte Aussagen treffen zu können. Meistens ist die Herausforderung, die Vielzahl der Parameterkombinationen auf ein Minimum zu reduzieren und dennoch die gewünschten Aussagen treffen zu können. Die gedruckten Proben werden hochauflösend mit einem Flachbettscanner digitalisiert und danach werden Bildverarbeitungsmethoden in den ingenieurstypischen Programmiersprachen Matlab oder Python angewendet. Beispielsweise wird eine Fast Fourier Transformation https://de.wikipedia.org/wiki/Schnelle_Fourier-Transformation (FFT) benutzt, um den dominanten Abstand der gedruckten Strukturen zu ermitteln. Die Automatisierung des Experiments und vor allem der anschließenden Auswertung ist ein weiterer wichtiger Punkt. Um zehntausende von gedruckten Mustern zu analysieren, wurde ein hochautomatisierter computergestützter Workflow entwickelt. Seit kurzem wird von Frau Brumm auch Künstliche Intelligenz, genauer gesagt Deep Learning https://de.wikipedia.org/wiki/Deep_Learning, zur Klassifizierung der gedruckten Muster verwendet. Dies ist notwendig, um die Skalierbarkeit hin zu industriellen Prozessen zu ermöglichen, indem umfangreiche Versuchsreihen an industriellen Maschinen durchgeführt und automatisiert ausgewertet werden. Diese werden anschließend mit kleineren Versuchsreihen an speziell entwickelten Labormaschinen verglichen, bei denen teilweise auch Modellfluide anstelle von realen Druckfarben verwendet werden. Bei Laborexperimenten werden in Teilprojekt C01 im SFB 1194 auch Hochgeschwindigkeitsvideos der hochdynamischen Grenzflächeninstabilität aufgenommen, die noch tiefere Einblicke in die Strömungsdynamik bieten und die industriellen Experimente ergänzen und erklären sollen. Der Maschinenbau ist sehr breit gefächert und das Studium muss dementsprechend auch breite Kenntnisse vermitteln. Beispielsweise werden umfangreiche Methoden aus der Mathematik gelehrt, damit ein/e Maschinenbau-Absolvent/in für die diversen Anwendungsaufgaben gerüstet ist. In der modernen Forschung ist die Fähigkeit zur interdisziplinären Zusammenarbeit und zur Wissenschaftskommunikation sehr entscheidend. Maschinenbauer/innen im SFB 1194 arbeiten beispielsweise mit Mathematikern/innen, Physikern/innen und Informatikern/innen zusammen, um eine größere Forschungsfrage zu beantworten. In dieser Podcast-Folge wird auch an junge Frauen appelliert, ein MINT-Studium auszuprobieren, um mehr Diversität im Studium, Forschung und Industrie zu erreichen, um am Ende noch innovativere Lösungen zu schaffen, die der Welt einen Nutzen bringen. LITERATUR UND WEITERFÜHRENDE INFORMATIONEN __ __ PODCASTS __ __

Gudrun spricht in dieser Folge mit Sarah Bischof, Timo Bohlig und Jonas Albrecht. Die drei haben im Sommersemester 2021 am Projektorientiertes Softwarepraktikum https://www.lbrg.kit.edu/page/projsoftpr teilgenommen. Das Praktikum wurde 2010 als forschungsnaher Lernort konzipiert. Studierende unterschiedlicher Studiengänge arbeiten dort ein Semester lang an konkreten Strömungssimulationen. Es wird regelmäßig im Sommersemester angeboten. Seit 2014 liegt als Programmiersprache die Open Source Software OpenLB https://www.openlb.net/ zugrunde, die ständig u.a. in der Karlsruher Lattice Boltzmann Research Group (LBRG) https://www.lbrg.kit.edu/ weiter entwickelt wird. Konkret läuft das Praktikum etwa folgendermaßen ab: Die Studierenden erhalten eine theoretische Einführung in Strömungsmodelle, die Idee von Lattice-Boltzmann-Methoden und die Nutzung der Hochleistungrechner am KIT. Außerdem finden sie sich für ein einführendes kleines Projekt in Gruppen zusammen. Anschließend wählen sie aus einem Katalog eine Frage aus, die sie bis zum Ende des Semesters mit Hilfe von Computersimulationen gemeinsam beantworten. Diese Fragen sind Teile von Forschungsthemen der Gruppe, z.B. aus Promotionsprojekten oder Drittmittelforschung. Während der Projektphase werden die Studierenden von dem Doktoranden/der Doktorandin der Gruppe, die die jeweilige Frage gestellt haben, betreut. Am Ende des Semesters werden die Ergebnisse in Vorträgen vorgestellt und diskutiert oder es wird eine Podcastfolge aufgenommen. In einer Ausarbeitung werden außerdem die Modellbildung, die Umsetzung in OpenLB und die konkreten Simulationsergebnisse ausführlich dargelegt und in den aktuellen Forschungsstand eingeordnet. Sarah, Timo und Jonas sind am KIT im Masterstudiengang Chemieingenieurwesen https://www.ciw.kit.edu/1629.php eingeschrieben. Neben den verschiedenen Masterstudiengängen Mathematik kommen aus diesem Studiengang die meisten Interessenten für das Softwarepraktikum. Im Podcast erläutern sie, was sie an der Strömungssimulation interessiert und inwieweit sie sich gut oder auch nicht so gut auf die Anforderungen vorbereitet gefühlt haben, wie sie sich die Arbeit in der Gruppe aufgeteilt haben und was sie an fachlichen und überfachlichen Dingen dort gelernt haben. Das Thema des Projektes war ein Benchmark https://de.wikipedia.org/wiki/Benchmark für die Durchströmung der Aorta https://de.wikipedia.org/wiki/Aorta. Dies ist einer der Showcases für OpenLB, die auf den ersten Blick die Leistungsfähigkeit der Software demonstrieren sollen. Das Projekt wurde von der Gruppe in drei Teile gegliedert: __ __ Mit Hilfe der Benchmark Tests auf dem HPC konnte die maximale Skalierbarkeit des Aorta Source Codes in Abhängigkeit der Problemgröße gefunden werden. Sie gibt an, auf wie vielen Computerprozessoren der Showcase mit der höchsten Performance simuliert werden kann. Des Weiteren wurde die parallele Effizienz mit Hilfe der Speedup https://de.wikipedia.org/wiki/Speedup Kennzahl untersucht. Diese beschreibt inwiefern sich die Simulationszeit infolge von Erhöhung der Prozessoranzahl verringert. In beiden Fällen zeigten die Performanceindikatoren ein Maximum bei 400-700 Prozessoreinheiten für Problemgrößen bis zu einer Resolution von N = 80. Das Softwarepaket OpenLB beinhaltet in Release 1.4r0 keine detaillierten Schnittstellen zur Performancemessung. Durch eine Source Code Erweiterung konnte eine interne Zeitmessung der einzelnen Funktionen des Codes realisiert werden. Dabei wurden so genannte Bottlenecks https://en.wikipedia.org/wiki/Bottleneck_(software) identifiziert und dokumentiert, welche durch Updates in zukünftigen Versionen der Software eliminiert werden sollen. Des Weiteren konnte auch durch die Code Erweiterung eine Aussage über die Parallelisierung getroffen werden. Im Vergleich zu den Benchmark Tests können direkt Funktionen des Source Codes, die die Parallelisierung hemmen, bestimmt werden. Die Performance Analyse durch das externe Programm und durch die Source Code Erweiterung bestätigen eine gut funktionierende Parallelisierung. Die Realisierung erfolgte dabei durch die Messung der Laufzeit der Hauptschritte einer OpenLB Simulation, sowie der detaillierten Analyse einzelner Funktionen. Diese finden sich zum aktuellen Zeitpunkt im Post-Processing des "Collide And Stream" Schrittes der Simulation. Collide And Stream beschreibt einen lokalen Berechnungsschritt, einen lokalen und einen nicht lokalen Übertragungsschritt. Der Kollisionsschritt bestimmt ein lokales Gleichgewicht der Massen-, Momenten- und Energiebilanzen. Im nicht-lokalen Streaming Schritt werden diese Werte auf die angrenzenden Blöcke des Simulationsgitters übertragen. Dies ermöglicht im Vergleich zu CFD-Simulationen, die auf Basis der Finite-Volumen-Methode https://de.wikipedia.org/wiki/Finite-Volumen-Verfahren (FVM) die Navier-Stokes Gleichungen https://de.wikipedia.org/wiki/Navier-Stokes-Gleichungen lösen, effizientere Parallelisierung insbesondere bei Einsatz einer HPC-Einheit. Die Post Prozessoren im Collide And Stream wenden unter anderem bestimmte, im vorangegangenen Schritt gesetzte Randbedingungen auf definierte Bereiche der Simulationsgeometrie an. Sie werden dabei nur für nicht-lokale Randbedingungen verwendet, weitere Randbedingungen können auch innerhalb des Kollisionsschrittes modelliert werden. Im Showcase der Aorta ist für das Fluid (Blut) am Eingang der Simulation eine Geschwindigkeits-Randbedingung nach Bouzidi mit Poiseuille-Strömungsprofil und am Ausgang eine "stress-free" Bedingung gewählt. Für die Aortawand ist eine no-slip Bedingung mit Fluidgeschwindigkeit null implementiert (Für genauere Informationen zum Simulationsaufbau hier https://link.springer.com/chapter/10.1007%2F978-3-642-36961-2_5 und hier https://doi.org/10.1002/jmri.25366. Die Laufzeit der Post-Processor Funktionen, deren Aufgabe es ist die Randbedingungen anzuwenden, können mit dem Timer des Release 1.4r0 nicht analysiert werden. Mit Blick auf spätere Releases ist es mit der Source Code Erweiterung nun möglich mit geringem Aufwand Daten über die Effizienz der vorhandenen, neuer oder verbesserter Funktionen in OpenLB zu gewinnen. Eine integrierte Zeitmessung als Analysetool kann einen direkten Einfluss auf die Performance des Source Codes haben, weshalb mit Hilfe der externen Software AMDµProf http://developer.amd.com/wordpress/media/2013/12/AMDuprof-User_Guide.pdf die Bottlenecks validiert wurden. Sowohl bei der internen als auch externe Performance Analyse sind die selben Post-Processing Schritte als Bottlenecks erkennbar, welches die Code Erweiterung validiert. Zusätzlich konnte mit der AMDμProf-Software die aktuelle OpenLB Version 1.4r0 mit der vorherigen Version 1.3r1 verglichen werden. Dabei fällt auf, dass sich die Bottlenecks vom Berechnungsschritt in Collide And Stream (Release 1.3r1) zum Post-Processing Schritt in Collide And Stream (Release 1.4r0) verschoben haben. Abschließend wurde eine vektorisierte Version von OpenLB erfolgreich getestet und ebenfalls auf Bottlenecks untersucht. Eine Vektorisierung eines Codes, auch bekannt als SIMD https://de.wikipedia.org/wiki/Flynnsche_Klassifikation#SIMD_(Single_Instruction,_Multiple_Data), soll die Parallelisierung verbessern und der Aorta Simulation eine bessere Performance verleihen. Das Bottleneck des Post-Processing Schritts in Collide And Stream, speziell durch Implementierung neuer Bouzidi Boundaries, wurde durch eine weitere Gruppe im Rahmen des Projektorientierten Softwarepraktikums optimiert. Es konnte eine Performance Verbesserung um einen Faktor 3 erreicht werden (mit OpenMP Compiler). Durch eine gezielte Analyse der Bottlenecks im Code konnte das Potential für die Beschleunigung der Simulation erweitert werden. Aber natürlich lohnt es sich hier weiterhin anzusehen, wo noch konkretes Potential für die Beschleunigung der Simulation liegt. Zumal seit dem letzten Relounch einige Pardigmen in der Software OpenLB verändert wurden. * PODCASTS __ __ * LITERATUR UND WEITERFÜHRENDE INFORMATIONEN __ __

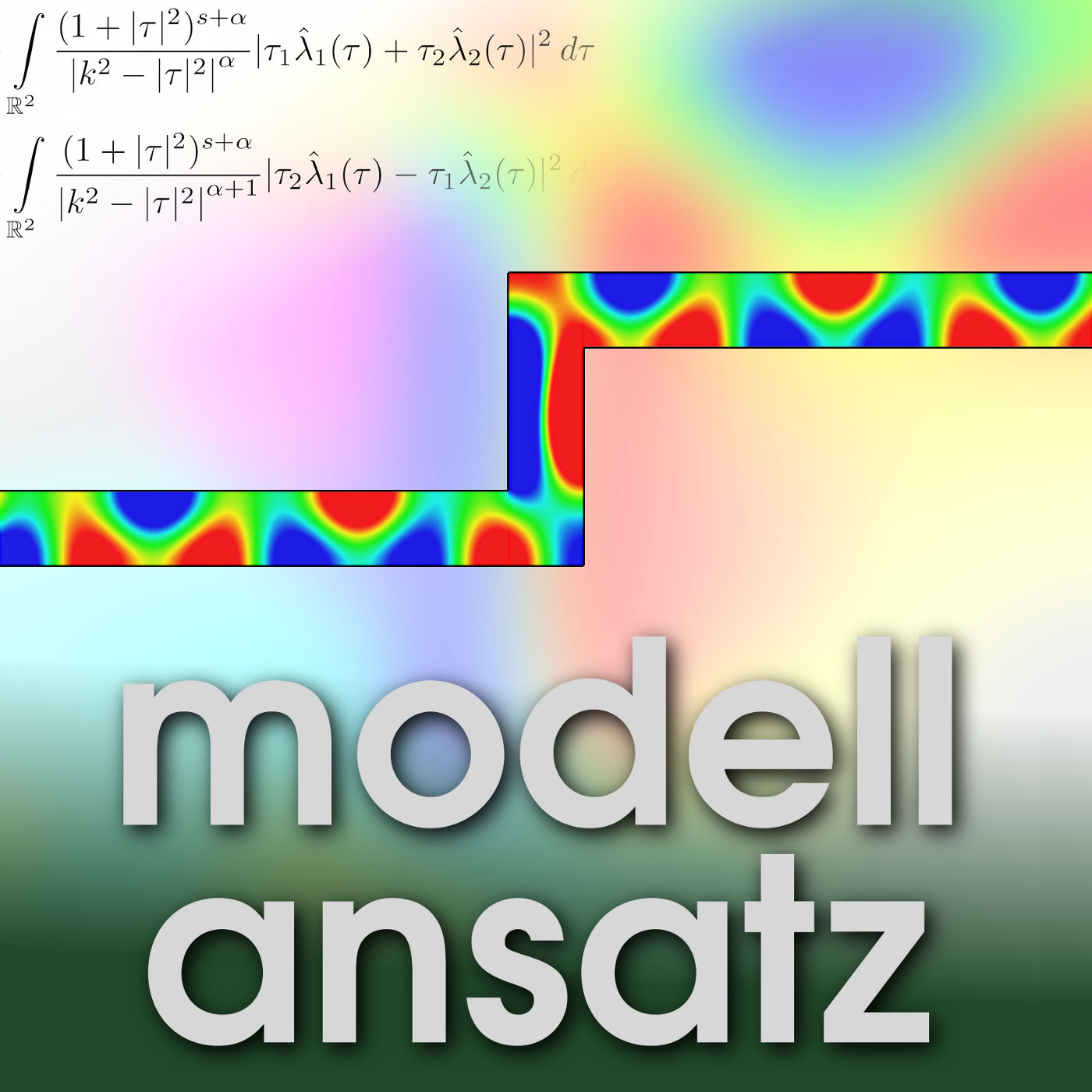

Gudrun spricht in dieser Folge mit Mathis Fricke https://www.mma.tu-darmstadt.de/index/mitarbeiter_3/mitarbeiter_details_mma_48384.en.jsp von der TU Darmstadt https://www.tu-darmstadt.de/ über Dynamische Benetzungsphänomene. Er hat 2020 in der Gruppe Mathematical Modeling and Analysis https://www.mma.tu-darmstadt.de/index/index.en.jsp bei Prof. Dieter Bothe https://www.mma.tu-darmstadt.de/index/mitarbeiter_3/mitarbeiter_details_mma_43073.en.jsp promoviert. Diese Gruppe ist in der Analysis und damit in der Fakultät für Mathematik angesiedelt, arbeitet aber stark interdisziplinär vernetzt, weil dort Probleme aus der Verfahrenstechnik modelliert und simuliert werden. Viele Anwendungen in den Ingenieurwissenschaften erfordern ein tiefes Verständnis der physikalischen Vorgänge in mehrphasigen Strömungen, d.h. Strömungen mit mehreren Komponenten. Eine sog. "Kontaktlinie" entsteht, wenn drei thermodynamische Phasen zusammenkommen und ein komplexes System bilden. Ein typisches Beispiel ist ein Flüssigkeitströpfchen, das auf einer Wand sitzt (oder sich bewegt) und von der Umgebungsluft umgeben ist. Ein wichtiger physikalischer Parameter ist dabei der "Kontaktwinkel" zwischen der Gas/Flüssig-Grenzfläche und der festen Oberfläche. Ist der Kontaktwinkel klein ist die Oberfläche hydrophil (also gut benetzend), ist der Kontaktwinkel groß ist die Oberläche hydrophob (schlecht benetzend). Je nach Anwendungsfall können beide Situationen in der Praxis gewollt sein. Zum Beispiel können stark hydrophobe Oberflächen einen Selbstreinigungseffekt aufweisen weil Wassertropfen von der Oberfläche abrollen und dabei Schmutzpartikel abtransportieren (siehe z.B. https://de.wikipedia.org/wiki/Lotoseffekt). Dynamische Benetzungsphänomene sind in Natur und Technik allgegenwärtig. Die Beine eines Wasserläufers nutzen eine ausgeklügelte hierarchische Oberflächenstruktur, um Superhydrophobie zu erreichen und das Insekt auf einer Wasseroberfläche leicht stehen und laufen zu lassen. Die Fähigkeit, dynamische Benetzungsprozesse zu verstehen und zu steuern, ist entscheidend für eine Vielzahl industrieller und technischer Prozesse wie Bioprinting und Tintenstrahldruck oder Massentransport in Mikrofluidikgeräten. Andererseits birgt das Problem der beweglichen Kontaktlinie selbst in einer stark vereinfachten Formulierung immer noch erhebliche Herausforderungen hinsichtlich der fundamentalen mathematischen Modellierung sowie der numerischen Methoden. Ein übliche Ansatz zur Beschreibung eines Mehrphasensystems auf einer makroskopischen Skala ist die Kontinuumsphysik, bei der die mikroskopische Struktur der Materie nicht explizit aufgelöst wird. Andererseits finden die physikalischen Prozesse an der Kontaktlinie auf einer sehr kleinen Längenskala statt. Man muss daher das Standardmodell der Kontinuumsphysik erweitern, um zu einer korrekten Beschreibung des Systems zu gelangen. Ein wichtiges Leitprinzip bei der mathematischen Modellierung ist dabei der zweite Hauptsatz der Thermodynamik, der besagt, dass die Entropie eines isolierten Systems niemals abnimmt. Dieses tiefe physikalische Prinzip hilft, zu einem geschlossenen und zuverlässigen Modell zu kommen. Die größte Herausforderung in der kontinuumsmechanischen Modellierung von dynamischen Benetzungsprozessen ist die Formulierung der Randbedingungen für die Navier Stokes Gleichungen an der Festkörperoberfläche sowie am freien Rand zwischen Gas und Flüssigkeit. Die klassische Arbeit von Huh und Scriven hat gezeigt, dass die übliche Haftbedingung ("no slip") an der Festkörperoberfläche nicht mit einer bewegten Kontaktlinie und damit mit einem dynamischen Benetzungsprozess verträglich ist. Man kann nämlich leicht zeigen, dass die Lösung für die Geschwindigkeit in diesem Fall unstetig an der Kontaktlinie wäre. Weil das Fluid (z.B. Wasser) aber eine innere Reibung (Viskosität) besitzt, würde dann mit einer unendlichen Rate ("singulär") innere Energie in Wärme umgewandelt ("dissipiert"). Dieses Verhalten ist offensichtlich unphysikalisch und zeigt dass eine Anpassung des Modells nötig ist. Einer der wesentlichen Beiträge von Mathis Dissertation ist die qualitative Analyse von solchen angepassten Modellen (zur Vermeidung der unphysikalischen Singularität) mit Methoden aus der Geometrie. Die Idee ist hierbei eine systematische Untersuchung der "Kinematik", d.h. der Geometrie der Bewegung der Kontaktlinie und des Kontaktwinkels. Nimmt man das transportierende Geschwindigkeitsfeld als gegeben an, so kann man einen fundamentalen geometrischen Zusammenhang zwischen der Änderungsrate des Kontaktwinkels und der Struktur des Geschwindigkeitsfeldes herleiten. Dieser geometrische (bzw. kinematische) Zusammenhang gilt universell für alle Modelle (in der betrachteten Modellklasse) und erlaubt tiefe Einsichten in das qualitative Verhalten von Lösungen. Neben der mathematischen Modellierung braucht man auch numerische Werkzeuge und Algorithmen zur Lösung der resultierenden partiellen Differentialgleichungen, die typischerweise eine Variante der bekannten Navier-Stokes-Gleichungen sind. Diese nichtlinearen PDE-Modelle erfordern eine sorgfältige Auswahl der numerischen Methoden und einen hohen Rechenaufwand. Mathis entschied sich für numerische Methoden auf der Grundlage der geometrischen VOF (Volume-of-Fluid) Methode. Die VOF Methode ist eine Finite Volumen Methode und basiert auf einem diskreten Gitter von würfelförmigen Kontrollvolumen auf dem die Lösung des PDE Systems angenähert wird. Wichtig ist hier insbesondere die Verfolgung der räumlichen Position der freien Grenzfläche und der Kontaktlinie. In der VOF Methode wird dazu für jede Gitterzelle gespeichert zu welchem Anteil sie mit Flüssigkeit bzw. Gas gefüllt ist. Aus dieser Information kann später die Form der freien Grenzfläche rekonstruiert werden. Im Rahmen von Mathis Dissertation wurden diese Rekonstruktionsverfahren hinsichtlich Ihrer Genauigkeit nahe der Kontaktlinie weiterentwickelt. Zusammen mit komplementären numerischen Methoden sowie Experimenten im Sonderforschungsbereich 1194 https://www.sfb1194.tu-darmstadt.de/ können die Methoden in realistischen Testfällen validiert werden. Mathis hat sich in seiner Arbeit vor allem mit der Dynamik des Anstiegs einer Flüssigkeitssäule in einer Kapillare sowie der Aufbruchdynamik von Flüssigkeitsbrücken (sog. "Kapillarbrücken") auf strukturierten Oberflächen beschäftigt. Die Simulation kann hier als eine numerische "Lupe" dienen und Phänomene sichtbar machen die, z.B wegen einer limitierten zeitlichen Auflösung, im Experiment nur schwer sichtbar gemacht werden können. Gleichzeitig werden die experimentellen Daten genutzt um die Korrektheit des Modells und des numerischen Verfahrens zu überprüfen. * LITERATUR UND WEITERFÜHRENDE INFORMATIONEN __ __ 229(10), 1849–1865 (2020). __ __ * PODCASTS __ __

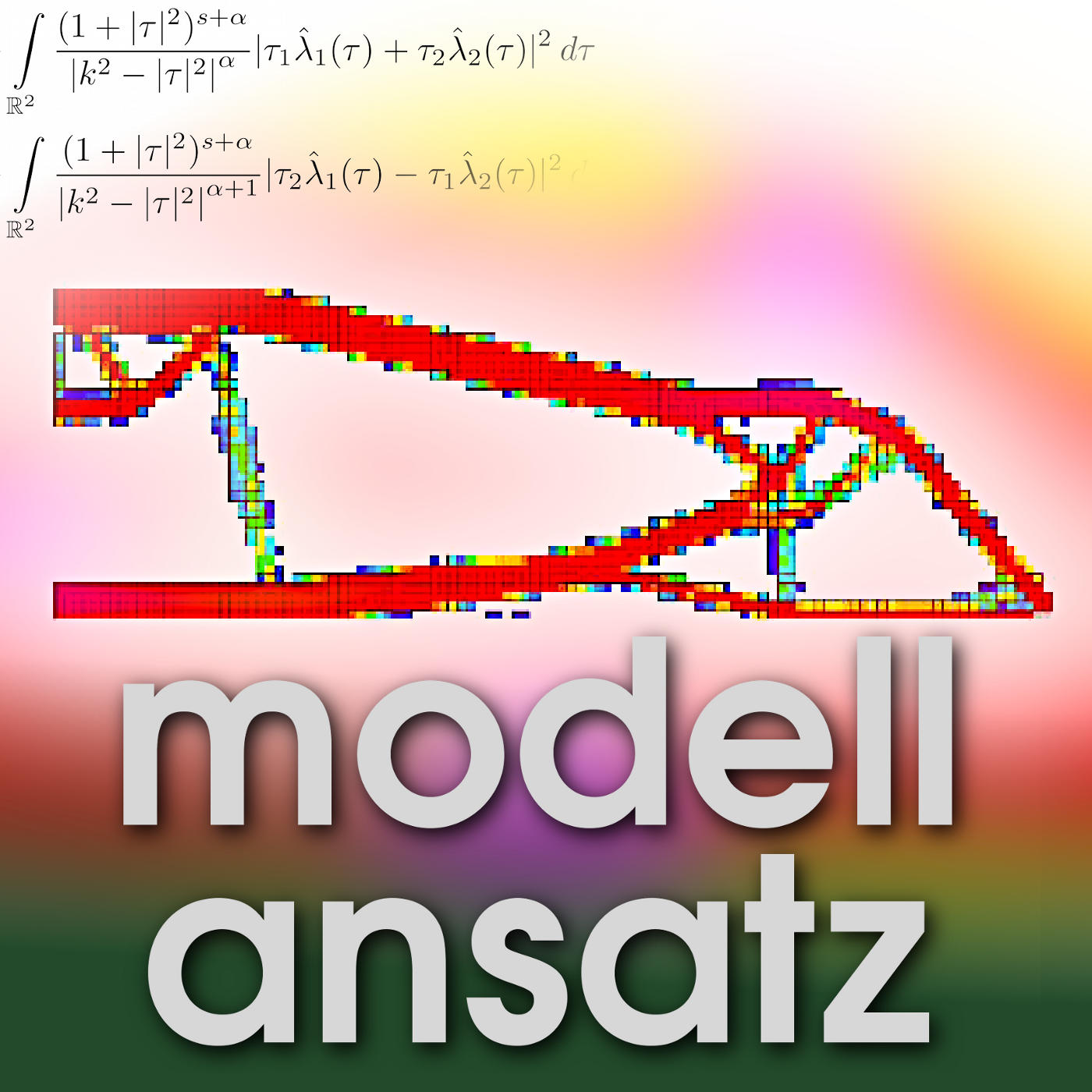

Gudrun spricht in dieser Folge mit Attila Genda über sein Praktikum bei Dassault Systèmes https://www.3ds.com/de/ (Standort Karlsruhe), das er m Frühjahr und Sommer 2020 im Rahmen seines Masterstudiums Technomathematik absolviert hat. Bei Dassault Systèmes in Karlsruhe wird schon seit einigen Jahrzehnten Strukturoptimierung betrieben. Wir haben dort auch schon einige Podcastfolgen zu den mathematischen Hintergründen und den aktuellen Weiterentwicklungen aufgenommen (s.u.). Für die numerische Lösung der betrachteten partiellen Differentialgleichungen werden Finite Elemente Verfahren https://de.wikipedia.org/wiki/Finite-Elemente-Methode eingesetzt. Grundlage einer jeden Strukturoptimierung ist ein mathematisches Optimierungsproblem unter Nebenbedingungen. Dazu werden eine Zielgröße und mehrere Nebenbedingungen definiert. Die Zielgröße ist dabei abhängig von zu bestimmenden Variablen, die als Unbekannte oder Optimierungsparameter bezeichnet werden. Die Nebenbedingungen sind Bedingungen an die Variablen, die erfüllt sein müssen, damit die Löung ”zulässig“ ist. Das Ziel der Optimierung ist nun die Minimierung der Zielgröße unter Einhaltung der Nebenbedingungen. Um konkrete Probleme zu lösen, gibt es eine Bandbreite verschiedener Löungsmöglichkeiten, die jeweils auf die Aufgabenstellung zugeschnitten werden. Alle Löser bzw. Minimierungsprobleme haben jedoch gemein, dass sowohl die Konvexität der Zielfunktion https://de.wikipedia.org/wiki/Konvexe_und_konkave_Funktionen als auch die Konvexität des Designgebiets https://de.wikipedia.org/wiki/Konvexe_Menge von fundamentaler Bedeutung für die Lösbarkeit des Problems sind. Strukturoptimierung verändert die Form eines Bauteils oder einer Baugruppe so, dass weniger Material nötig ist, aber vorgegebene Festigkeitsanforderungen (z.B. Spannungen, denen das Teil typischerweise ausgesetzt ist) erfüllt sind. Dabei darf sich die Materialverteilung frei in approximativen Schritten verändern und ist nicht durch eine Vorplanung der prinzipiell einzuhaltenden äußeren Form begrenzt. Dies führt z.B. zur Entstehung von Löchern in der Form des Bauteils, was die Topologie auch im mathematischen Sinne verändert. Das ist kompliziert und einfach zugleich - je nachdem, unter welchem Blickwinkel man es betrachtet. Die Einfachheit ergibt sich aus der Tatsache, dass keine Zellen aus dem numerischen Netz der Numerik entfernt werden. Man setzt einfach eine Variable, die angibt, ob dort Material vorhanden ist oder nicht. Anstatt dies jedoch mit binären Werten zu tun (d.h. Material "an" oder "aus"), ändert man die Materialdichte der Zelle kontinuierlich zwischen [0, 1]. Dabei steht 0 für kein Material und 1 für die volle Materialmenge. Um numerische Probleme zu vermeiden wird statt 0 eine kleine Zahl verwendet. Da diese Modellierung im Allgemeinen zu physikalisch nicht interpretierbaren Ergebnissen führt, bei denen die Zellen weder leer sind noch die volle Menge an Material enthalten, müssen wir sicherstellen, dass der Optimierer dazu neigt, Ergebnisse zu finden, bei denen die Anzahl der Zellen mit mittlerer Dichte minimal ist. Dazu bestrafen wir solche Konstruktionen. Diese Verfahren heißen Solid Isotropic Material with Penalization Method - kurz SIMP-Methode. Strukturoptimierungsaufgaben enthalten in der Regel eine sehr große Anzahl von Designvariablen, in der Praxis sind es nicht selten mehrere Millionen von Variablen, die die Zielfunktion beeinflussen. Demgegenüber ist die Zahl der Nebenbedingungen viel kleiner - oft gibt es sogar nur ein paar wenige. Da Strukturoptimierungsprobleme im Allgemeinem keine konvexen Promleme sind und oft auch keine linearen Probleme, ist die Auswertung des Zielfunktionals und der Nebenbedingungen sehr rechenintensiv. Deshalb wurden spezielle Algorithmen entwickelt, die besonders geeignet für die Lösung solcher Probleme sind, weil sie vermeiden können, dass bis zur Konvergenz eine große Anzahl von Funktionsauswertungen stattfinden müssen. Der wahrscheinlich meist verbreitete Algorithmus heißt Method of Moving Asymptotes (MAA) https://de.wikipedia.org/wiki/Method_of_Moving_Asymptotes. Er wird in der Podcastepisode diskutiert. Die Aufgabe von Attila in seiner Zeit des Praktikums war es nämlich, diese Methode zu verallgemeinern, dann zum implementieren und die Implementierung zu testen. Die ursprünglich angewandte MAA-Methode, die von Svanberg vorgeschlagen wurde, verwendet nur einen sehr einfachen Ansatz zur Behandlung der Länge des Intervalls zwischen der unteren und oberen Asymptote. * LITERATUR UND WEITERFÜHRENDE INFORMATIONEN __ __ * PODCASTS __ __

Gudrun spricht mit Hartwig Anzt https://hartwiganzt.github.io/. Er leitet die Helmholtz-Nachwuchsgruppe Fixed-point methods for numerics at Exascale (FiNE) https://www.scc.kit.edu/en/aboutus/jrg-fine.php am SCC. Seine Forschung beschäftigt sich mit numerischer linearer Algebra in modernen Hochleistungsrechnersystemen. Angesichts des explosionsartigen Anstiegs der Hardware-Parallelität erfordert die effiziente Ausführung von Anwendungen auf solchen Systemen eine völlige Neugestaltung der zugrunde liegenden numerischen Methoden. Dieses neue Paradigma muss Implementierungen umfassen, die sich auf die Parallelität auf Knotenebene, ein reduziertes globales Kommunikationsvolumen und abgeschwächte Synchronisationsanforderungen konzentrieren. Hartwig ist Teil des PEEKS https://icl.utk.edu/peeks/ und xSDK https://xsdk.info/-Projekts und leitet die Multiprecision-Initiative im US Exascale Computing Project (ECP) https://www.exascaleproject.org/. Das Ziel dieser Initiative besteht darin, die Nutzung verschiedener arithmetischer Präzisionen in numerische Algorithmen zu erforschen, wodurch viele Algorithmen beschleunigt werden können, ohne dabei Genauigkeit einzubüßen. Hartwigs Forschungsschwerpunkt liegt auf der Entwicklung und Optimierung numerischer Methoden https://de.wikipedia.org/wiki/Numerische_Mathematik für effizientes Hochleistungsrechnen. Insbesondere interessiert er sich für lineare Algebra https://de.wikipedia.org/wiki/Lineare_Algebra für dünn besetzte Matrizen https://de.wikipedia.org/wiki/Dünnbesetzte_Matrix, iterative und asynchrone Methoden, Krylov-Löser https://de.wikipedia.org/wiki/Krylow-Unterraum-Verfahren und Vorkonditionierung https://de.wikipedia.org/wiki/Vorkonditionierung. Die zugrundeliegende Idee besteht darin, numerische Probleme als Fixpunktprobleme https://de.wikipedia.org/wiki/Fixpunktiteration umzuformulieren, um höhere Parallelisierungsgrade zu ermöglichen. Die Implementierung der Fixpunktmethoden macht typischerweise starken Gebrauch von (datenparallelen) Batch-Routinen und weist schwache Synchronisationsanforderungen auf. Die Algorithmenforschung wird ergänzt durch Bemühungen, die auf eine nachhaltige Software-Entwicklung in einem akademischen Umfeld und einen gesunden Software-Lebenszyklus https://de.wikipedia.org/wiki/Software-Lebenszyklus abzielen. Ein Ergebnis dieser Bemühungen ist Ginkgo https://github.com/ginkgo-project, eine Open Source Softwarebibliothek für numerische lineare Algebra mit dem Fokus auf Löser für dünn besetzte Systeme, die Hartwig ins Leben gerufen hat. Bei dem Stichwort Software-Nachhaltigkeit könnte man an das Vorhandensein eines Continuous Integration (CI)-Frameworks https://de.wikipedia.org/wiki/Kontinuierliche_Integration denken, also das Vorhandensein eines Test-Frameworks, das aus Unit-Tests https://de.wikipedia.org/wiki/Modultest, Integrationstests und End-to-End-Tests besteht (inkl. das Vorhandensein einer Software-Dokumentation). Wenn man jedoch fragt, was der übliche Todesstoß für ein wissenschaftliches Softwareprodukt ist, ist es oft die fehlende Plattform- und Leistungsportabilität. Vor diesem Hintergrund haben Hartwig und seine Gruppe wir Ginkgo-Bibliothek mit dem primären Fokus auf Plattform-Portabilität und der Fähigkeit, nicht nur auf neue Hardware-Architekturen zu portieren, sondern auch eine gute Performance zu erreichen, entwickelt. Die grundlegende Idee beim Design der Ginkgo-Bibliothek ist eine radikale Trennung der Algorithmen von den hardwarespezifischen Dingen. Daneben sprechen Gudrun und Hartwig über die Nutzung von Kalkülen mit geringer Genauigkeit für letztendlich präzise Algorithmen. Die Hardware-Anbieter haben nämlich damit begonnen, spezielle Funktionseinheiten mit geringer Genauigkeit zu entwickeln, um der Nachfrage z.B. der Machine-Learning-Community und deren Bedarf an hoher Rechenleistung in Formaten mit geringer Genauigkeit zu entsprechen. Hartwig konzentriert sich darauf, wie dann Mixed- und Multiprecision-Technologie helfen kann, die Leistung dieser Methoden zu verbessern und findet Anwendungen, die die traditionellen Methoden mit fester Genauigkeit deutlich übertreffen. * LITERATUR UND WEITERFÜHRENDE INFORMATIONEN __ __ * PODCASTS __ __